Günümüzde yapay zekanın donanım ve yazılım uygulamaları, yapay zeka ve sinir ağı operasyonlarını optimize etmek için özel olarak tasarlanmış hale gelecek şekilde ilerlemiştir. Bunlar, yapay zeka görevlerini hızlandırma yetenekleri açısından genellikle grafik işleme birimleriyle (GPU’lar) karşılaştırılan sinirsel işlem birimlerini (NPU’lar) içerir. NPU’lar, mümkün olan en yüksek hızlarda son teknoloji AI/ML görevleri için tasarlanmış, giderek yaygınlaşan donanım parçalarıdır. Peki bunlar nasıl farklı?

NPU’ları ve GPU’ları kısaca inceleyelim, farklılıklarını karşılaştıralım ve her birinin güçlü ve dezavantajlı yönlerini inceleyelim.

NPU nedir?

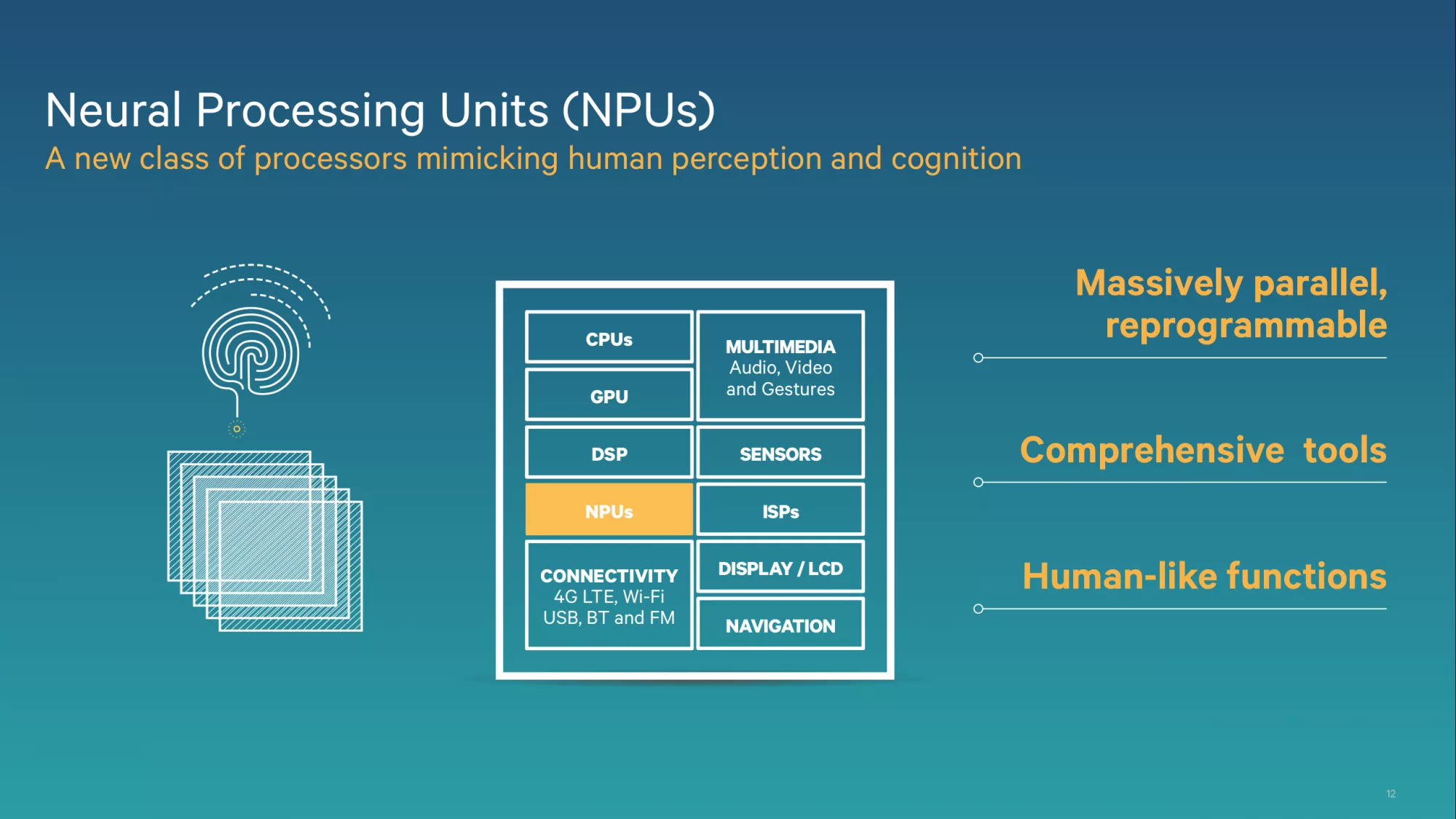

NPU, Nöral İşleme Birimi anlamına gelir. NPU, yapay zeka ve sinir ağlarıyla ilgili görevlerin performansını optimize etmek için tasarlanmış özel bir donanım parçasıdır.

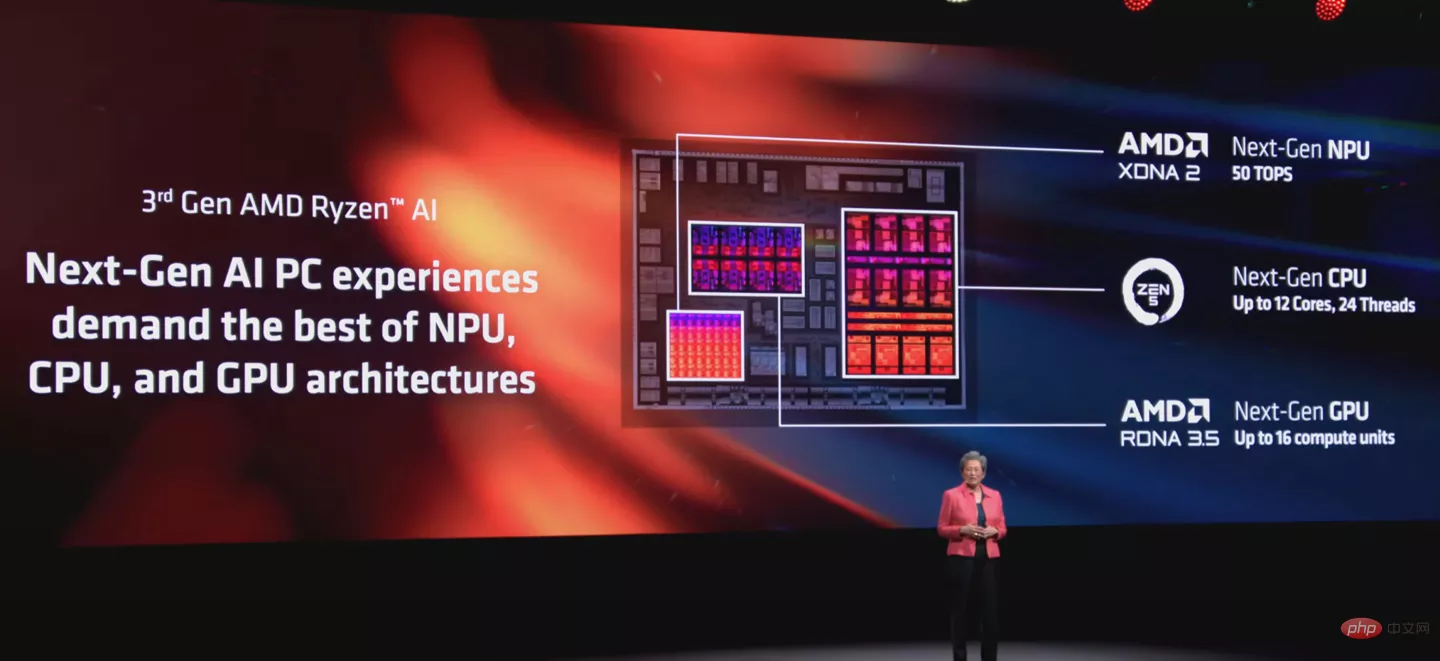

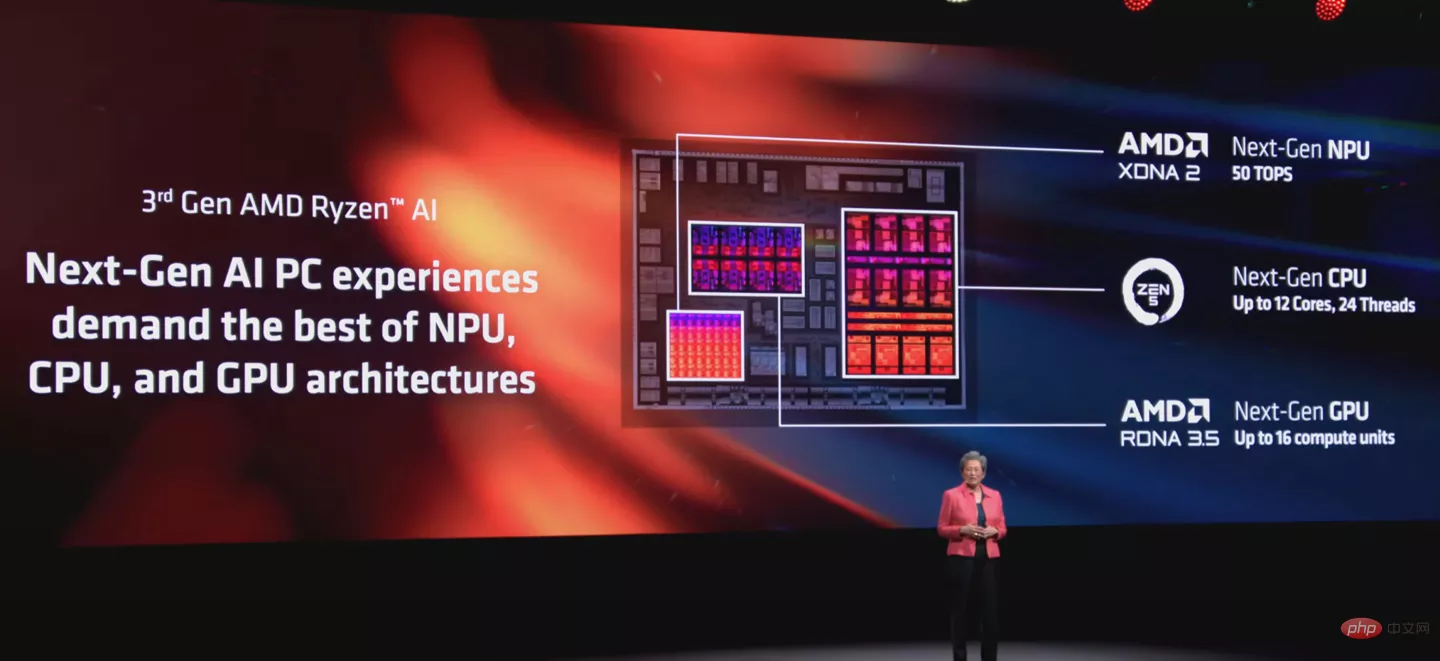

Bu, NPU’ların araştırma laboratuvarlarına ve askeri üslere aitmiş gibi görünmesine neden olabilir, ancak NPU’lar – nispeten yeni bir buluş olmasına rağmen – giderek daha yaygın hale geliyor. Yakında masaüstü ve dizüstü bilgisayarlarda NPU’ları görmeye başlayacaksınız ve son birkaç yıldaki iPhone’lar, Google Pixel ve Samsung Galaxy modelleri de dahil olmak üzere çoğu çağdaş akıllı telefonun ana CPU’larına entegre NPU’lar var.

// İlgili Öyküler

- Nvidia, oyunlardaki yapay zeka tarafından oluşturulan dokular ve NPC’ler için DLSS’nin geleceğine dair ipuçları veriyor

- PowerColor, harici bir NPU’dan yararlanarak GPU performansını artırabileceklerini iddia ediyor

İster inanın ister inanmayın, bu slayt 2013 Qualcomm SoC sunumundan alınmıştır. Moda bir kelime olarak “NPU” terimi ancak on yıl sonra dikkat çekmeye başladı.

Nöral işlem birimleri (adından da anlaşılacağı gibi) nöral motorları ve ağ algoritmalarını desteklemeye yardımcı olur ve bunlar otonom sürüş ve doğal dil işleme (NLP) gibi son derece gelişmiş ayarların yanı sıra yüz tanıma, ses tanıma ve görüntü işleme gibi rutin uygulamalarda kullanılır. telefonunda.

Editörün Notu:

Bu konuk blog yazısı, kurumsal all-flash veri depolama çözümlerine adanmış, ABD merkezli, halka açık bir teknoloji şirketi olan Pure Storage’ın personeli tarafından yazılmıştır. Pure Storage çok aktif bir blog tutuyor; bu onların “Tamamen Eğitici” gönderilerinden biri ve onların izniyle burada yeniden basıyoruz.

GPU nedir?

GPU, Grafik İşlem Birimi anlamına gelir. Başlangıçta görüntü oyunlarında ve multimedya uygulamalarında grafik oluşturmak için geliştirilen GPU kullanımları önemli ölçüde gelişti ve artık karmaşık hesaplamaları yöneten paralel işlem gerektiren birçok farklı uygulamada kullanılıyor.

GPU’ların benzersiz gücü, binlerce küçük görevi aynı anda ne kadar hızlı ve verimli bir şekilde gerçekleştirebildikleridir. Bu onları özellikle grafik oluşturma, fiziği simüle etme ve hatta sinir ağlarını eğitme gibi birçok eş zamanlı hesaplama içeren karmaşık görevlerde başarılı kılar.

NPU ve GPU: Farklılıklar

Mimari açıdan konuşursak, NPU’lar paralel işleme için GPU’lardan daha donanımlıdır. NPU’lar, GPU’lara kıyasla daha fazla sayıda daha küçük işlem birimine sahiptir. NPU’lar ayrıca derin öğrenme iş yüklerinin işlenmesini özellikle verimli hale getiren özel bellek hiyerarşilerini ve veri akışı optimizasyonlarını da içerebilir. GPU’lar, NPU’lara kıyasla daha fazla sayıda çok yönlü çekirdeğe sahiptir. Geçmişte bu çekirdekler paralel işleme yoluyla çeşitli hesaplama görevlerinde kullanılıyordu, ancak NPU’lar özellikle sinir ağı algoritmaları için iyi tasarlanmıştı.

NPU’lar özellikle kısa ve tekrarlanan görevlerle çalışma konusunda iyidir. Çağdaş bilgi işlem sistemlerine dahil edilen NPU’lar, GPU’ları sinir ağlarına özgü matris işlemlerini yürütme yükünden kurtarabilir ve GPU’yu işleme görevlerini veya genel amaçlı bilgi işlemi işlemeye bırakabilir.

GPU’larla karşılaştırıldığında NPU’lar, yoğun derin öğrenme hesaplamalarına dayanan görevlerde üstünlük sağlar. NLP, konuşma tanıma ve bilgisayar görüşü, NPU’ların GPU’lara göre üstün olduğu yerlere birkaç örnektir. GPU’lar, NPU’lara göre daha genel amaçlı bir mimariye sahiptir ve büyük ölçekli dil modellerini veya uç bilişim uygulamalarını işlemede NPU’larla rekabet etmekte zorlanabilirler.

NPU ve GPU: Performans

Yan yana konulduğunda NPU’lar ve GPU’lar arasındaki en büyük performans farkı verimlilik ve pil ömründedir. NPU’lar sinir ağı işlemleri için özel olarak tasarlandığından, GPU ile aynı işlemleri karşılaştırılabilir hızlarda yürütmek için çok daha az güce ihtiyaç duyarlar.

Bu karşılaştırma, iki donanım türü arasındaki mimari farklardan çok, sinir ağlarının mevcut karmaşıklığı ve uygulamasına ilişkin bir ifadedir. NPU’lar, AI/ML iş yükleri için mimari olarak optimize edilmiştir ve derin öğrenme çıkarımı ve eğitim gibi en karmaşık iş yüklerini yönetme konusunda GPU’ları geride bırakır.

NPU’larda matris çarpımları ve aktivasyon işlevleri için özel donanım, gerçek zamanlı dil çevirisi, otonom araçlarda görüntü tanıma ve tıbbi uygulamalarda görüntü analizi gibi görevlerde GPU’lara kıyasla üstün performans ve verimlilik elde ettikleri anlamına gelir.

Uygulama Sorunları ve Depolama Talepleri

Kurumsal düzeyde NPU’lar mevcut altyapıya ve veri işleme hatlarına entegre edilebilir. Yapay zeka görevleri için mümkün olan en yüksek hesaplama gücünü elde etmek amacıyla NPU’lar veri merkezlerinde CPU’lar, GPU’lar ve diğer hızlandırıcılarla birlikte dağıtılabilir. Ancak tüm AI/ML işleme öğeleri kurumsal veri merkezi operasyonlarına dahil edildiğinde veri erişimi ve depolama tehlikeleri ortaya çıkabilir.

AI/ML iş yüklerini işleyen tamamen optimize edilmiş NPU’lar ve GPU’lar, veriyi o kadar yüksek hızlarda işleyebilir ki, geleneksel depolama sistemleri buna ayak uydurmakta zorlanabilir, bu da veri alma ve işlemede potansiyel darboğazlara yol açabilir.

Uygulamada, NPU’lar belirli depolama düzenlemelerini zorunlu kılmaz; ancak bunların en yüksek verimlilikte çalıştırılması, geniş veri kümelerine son derece hızlı erişime sahip olmalarına bağlıdır. AI/ML iş yüklerini işleyen NPU’lar, doğru modelleri eğitmek ve çıkarmak için genellikle büyük miktarda veriye ve ayrıca bu verileri son derece hızlı bir şekilde sıralama, erişme, değiştirme ve depolama becerisine ihtiyaç duyar. Bunun için kurumsal düzeyde çözümler, flash depolama ve bütünsel olarak yönetilen depolama altyapıları şeklinde gelir.

Özetlemek gerekirse, NPU’lar sinir ağı operasyonlarını yürütmek için özel olarak tasarlanmış ve tasarlanmıştır; bu da onları özellikle AI/ML operasyonlarıyla ilişkili küçük ve tekrarlayan görevlerin üstesinden gelmede etkili kılar.

Görünen o ki, GPU’lar kulağa benzer geliyor: küçük işlemleri aynı anda gerçekleştirmek için tasarlanmış donanım bileşenleri. Ancak NPU’lar, matris çarpımları ve aktivasyon fonksiyonları gibi görevlere yönelik optimizasyonları nedeniyle sinirsel iş yüklerinde açık bir avantaja sahiptir. Bu, özellikle verimlilik ve hız açısından derin öğrenme hesaplamalarını yönetme konusunda NPU’ları GPU’lardan üstün kılar.