Sonuç olarak:Yapay zeka sistemlerindeki son gelişmeler, karmaşık görüntüleri tanıma ve analiz etme yeteneklerini önemli ölçüde iyileştirdi. Ancak yeni bir makale, birçok son teknoloji görsel öğrenme modelinin, bir ızgaradaki satır ve sütun sayısını saymak veya iki satırın kaç kez kesiştiğini saymak gibi insanların kolay bulduğu basit görsel görevlerde zorlandığını ortaya koyuyor.

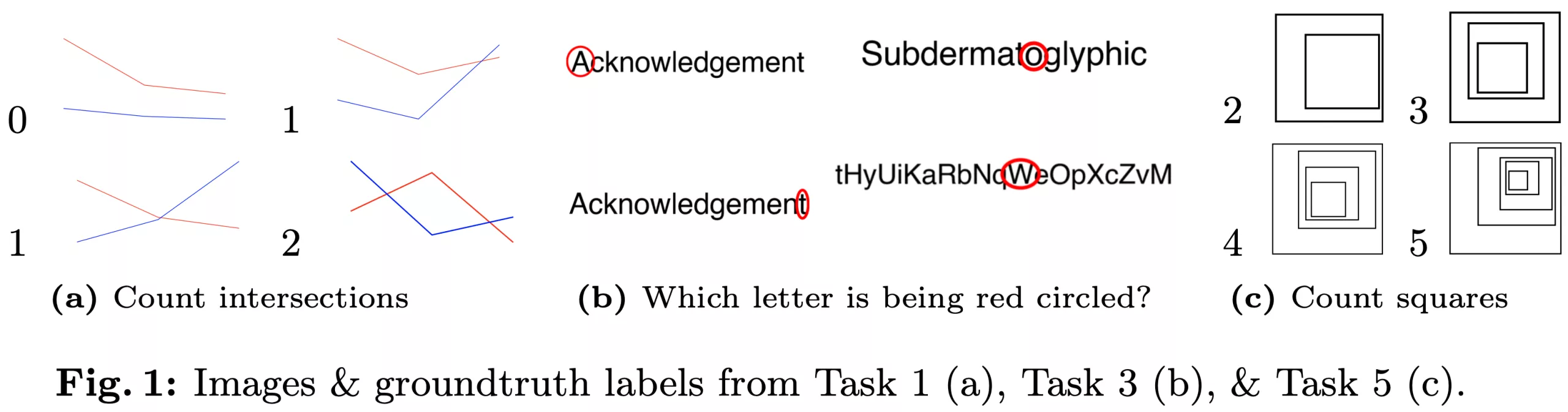

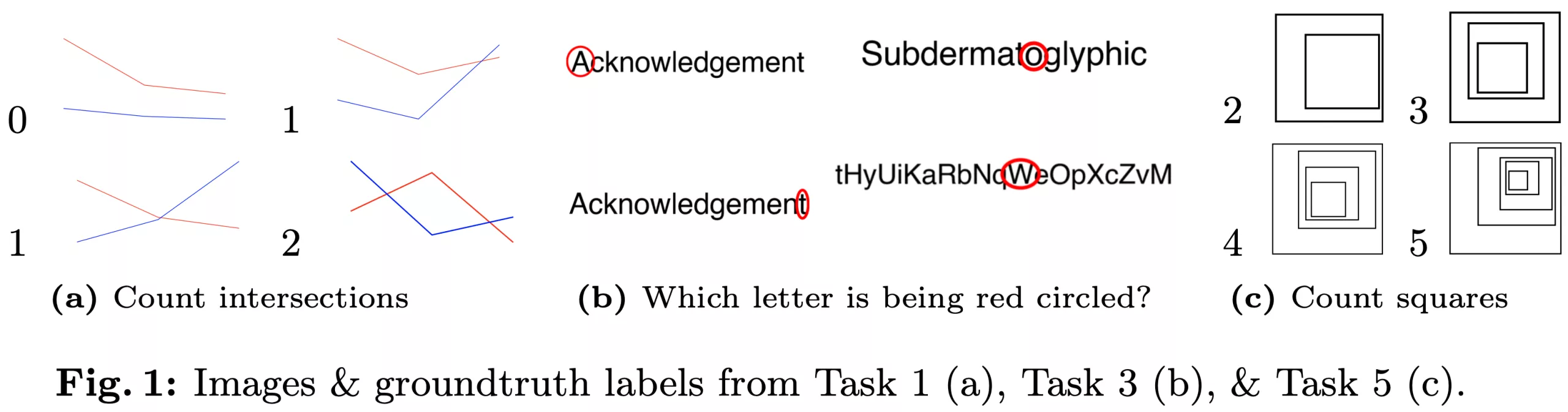

Auburn Üniversitesi ve Alberta Üniversitesi’nden araştırmacılar yakın zamanda “Görme dili modelleri kördür” başlıklı bir makale yayınladılar. Çalışmada görsel öğrenme modellerindeki (VLM) eksiklikleri vurgulamak için sekiz basit görme keskinliği testi kullanıldı. Görevler arasında kesişen çizgileri sayma, daire içine alınmış harfleri tanımlama, iç içe geçmiş şekilleri sayma ve diğerleri vardı. Bu testler nesnel olarak kesin yanıtlar içerir ve temel 2B şekillerin ötesinde asgari bilgi gerektirir.

Araştırmacılar, bu görevleri ezberleme yoluyla çözen modellerden kaçınmak için testleri önceden var olan görüntüler yerine özel kod kullanarak oluşturdular. GPT-4o, Gemini-1.5 Pro, Sonnet-3 ve Sonnet-3.5 dahil olmak üzere dört VLM modelini değerlendirdiler. Sonuçlar, modellerin hiçbirinin mükemmel doğruluk elde etmediğini ve performansın göreve bağlı olarak önemli ölçüde değiştiğini gösterdi.

Örneğin, en iyi performans gösteren model, boş bir ızgaradaki satırları ve sütunları yalnızca %60’tan daha az doğrulukla sayabiliyordu. Tersine, Gemini-1.5 Pro, daire içine alınmış harfleri %93 oranında doğru bir şekilde tanımlayarak insan seviyesindeki performansa yaklaştı.

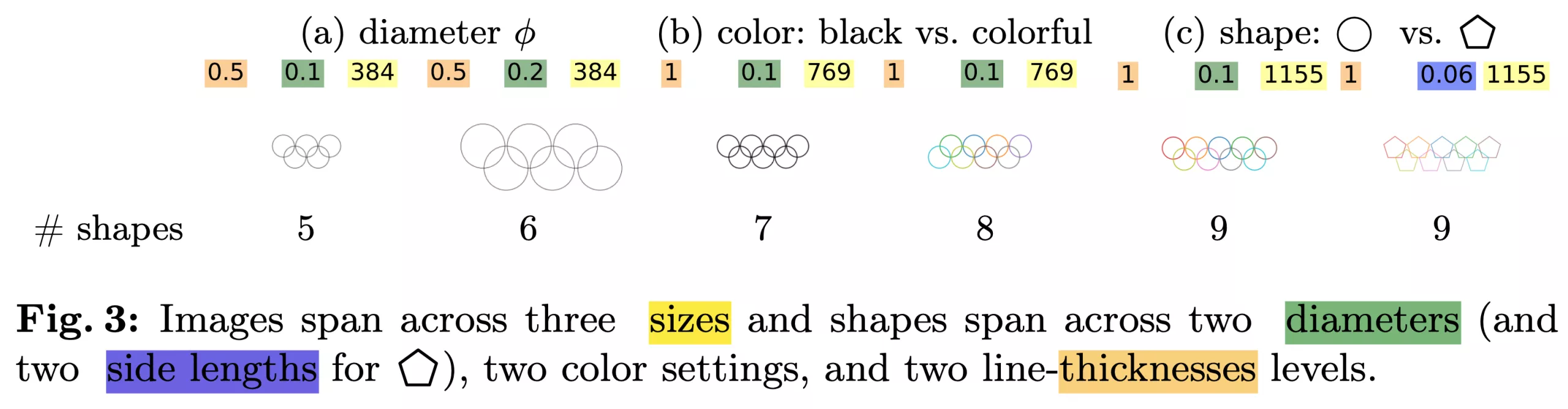

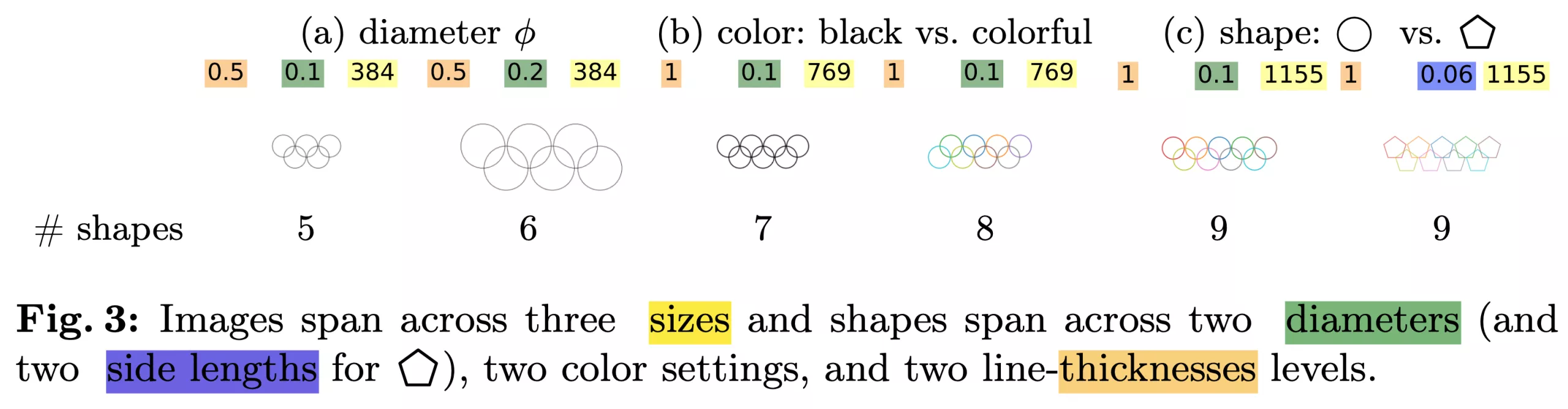

Dahası, görevlerde yapılan küçük değişiklikler bile önemli performans değişikliklerine yol açtı. Tüm modeller beş örtüşen daireyi doğru bir şekilde belirleyebilse de, daire sayısı altıya veya daha fazlasına çıktığında doğruluk yüzde 50’nin altına düştü (yukarıda). Araştırmacılar, doğruluktaki düşüşün Olimpiyat logosunun beş iç içe geçmiş halkasına yönelik bir önyargıdan kaynaklanabileceğini teorileştiriyor. Bazı modeller, “Subdermatoglyphic”teki daire içine alınmış harf için “9”, “n” veya “©” gibi anlamsız yanıtlar bile verdi (aşağıda).

// İlgili Öyküler

- Bu robot diğerlerinden daha yükseğe zıplayabiliyor ve bir gün gezegenleri keşfetmek için kullanılabilir

- Avustralya’nın yeni “çok gizli” bulut platformu AWS üzerine kurulacak

Bu bulgular, VLM’lerin düşük seviyeli soyut görsel görevleri ele alma becerisindeki önemli bir sınırlamanın altını çiziyor. Davranış, tutarlı metin özetleri üretebilen ancak temel matematik ve yazım sorularında başarısız olabilen büyük dil modellerindeki benzer yetenek boşluklarını anımsatıyor. Araştırmacılar, bu boşlukların modellerin eğitim verisinin ötesinde genelleme yapamamasından kaynaklanabileceğini varsaydılar. Ancak, görevlerden birinden (iki dairenin birbirine değmesi testi) belirli görüntülerle bir modeli ince ayarlamak, doğruluğu yalnızca %17’den %37’ye kadar orta düzeyde iyileştirdi; bu da modelin eğitim setine aşırı uyduğunu ancak genelleme yapamadığını gösteriyor.

Araştırmacılar, VLM’lerdeki bu yetenek boşluklarının, önceden eğitilmiş dil modellerine görme kodlayıcılarını entegre eden “geç birleştirme” yaklaşımından kaynaklanabileceğini öne sürüyorlar. Görsel ve dil eğitimini baştan birleştiren bir “erken birleştirme” yönteminin, düşük seviyeli görsel görevlerdeki performansı artırabileceğini öne sürüyorlar. Ancak, bu öneriyi destekleyecek bir analiz sunmadılar.

Sonuçları ve diğer örnekleri takımın web sitesinden inceleyebilirsiniz.